记一次批量刷漏洞

万事都有起因,这次也不例外。

这次起因是补天又搞了个活动,听说有证书拿,为了刷刷简历,所以就….。

这次的活动范围就是补天里面的公益厂商,所以避免不了先爬抓下链接,上次我有爬抓过所以就不在重复了链接:爬抓360补天厂商的域名

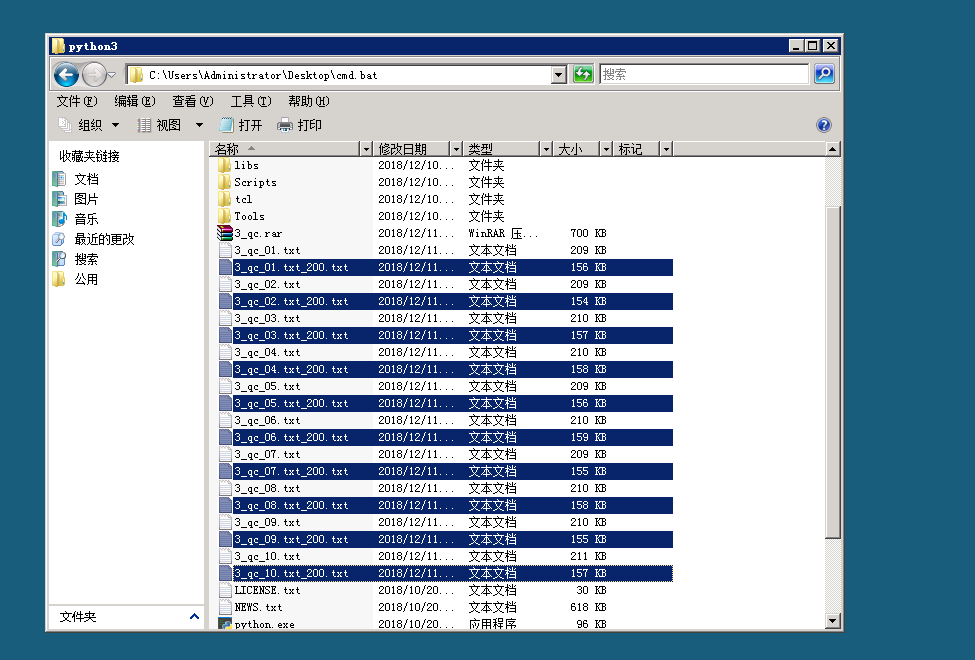

由于拿到的域名过多,所以得筛选一遍,先把打开返回值不是200的去掉。

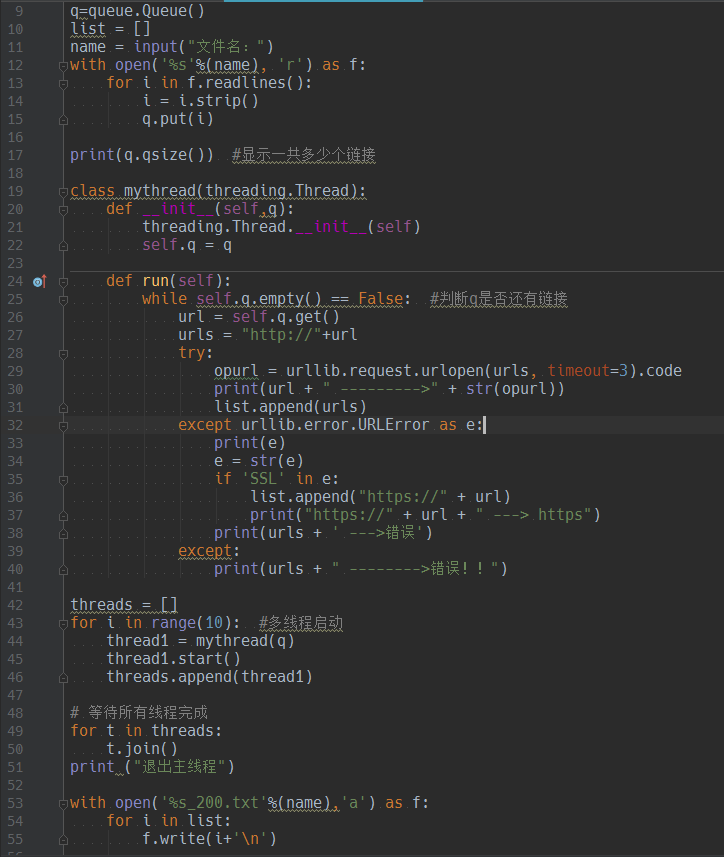

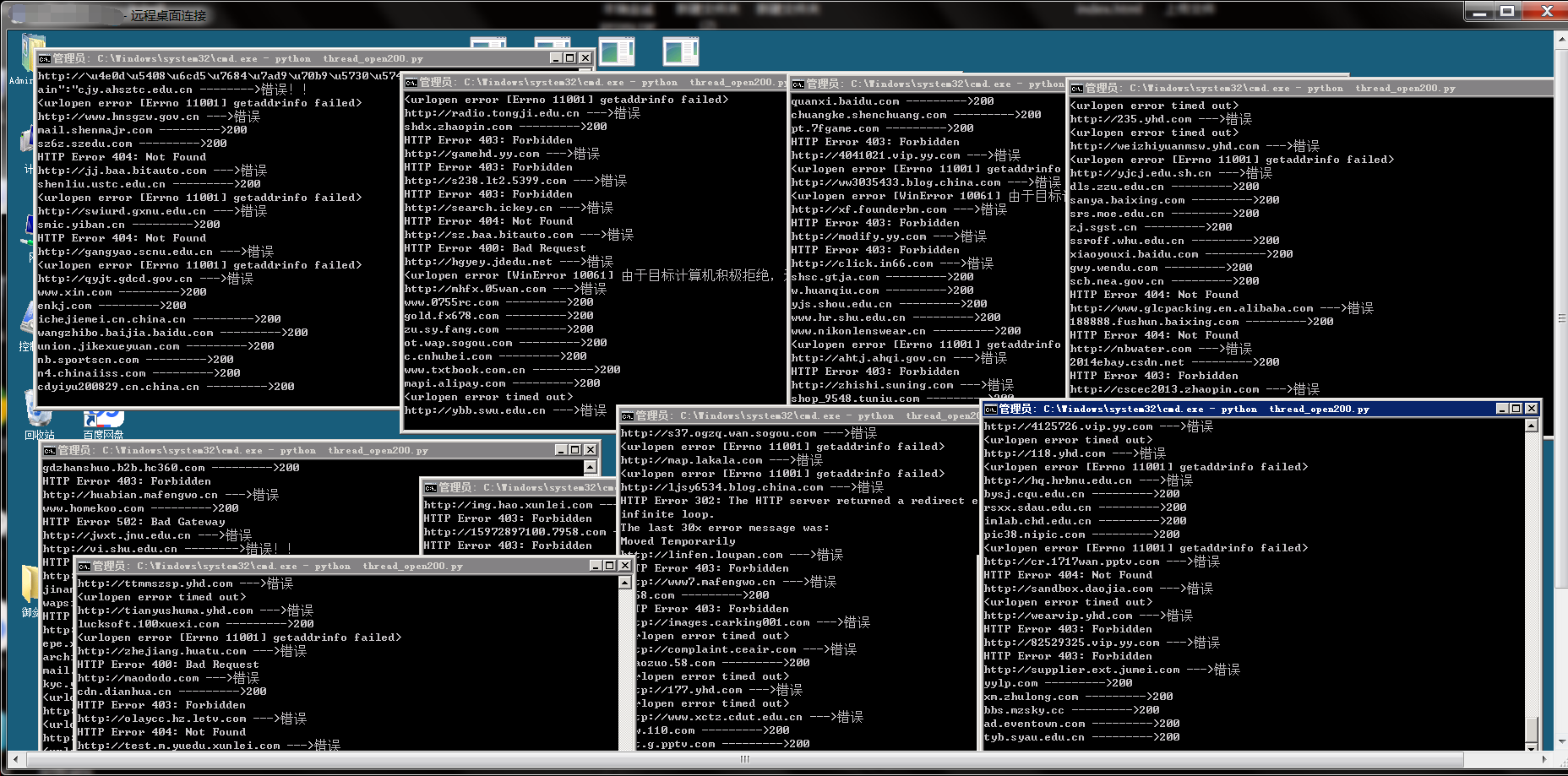

本来写的不是多线程的,因为效果太差,只能写个多线程的。

哪怕多线程的效果相对十几万的的url而言,效果也不是那么美好。

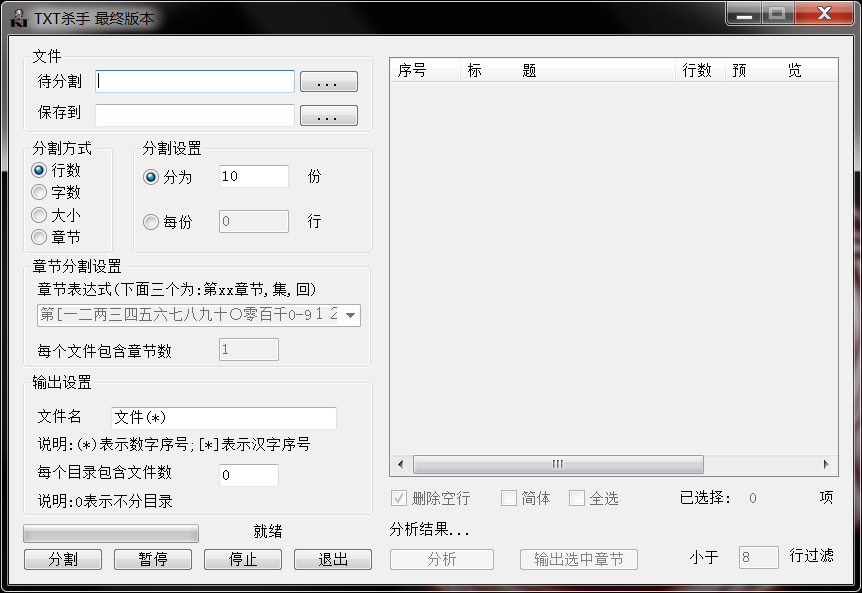

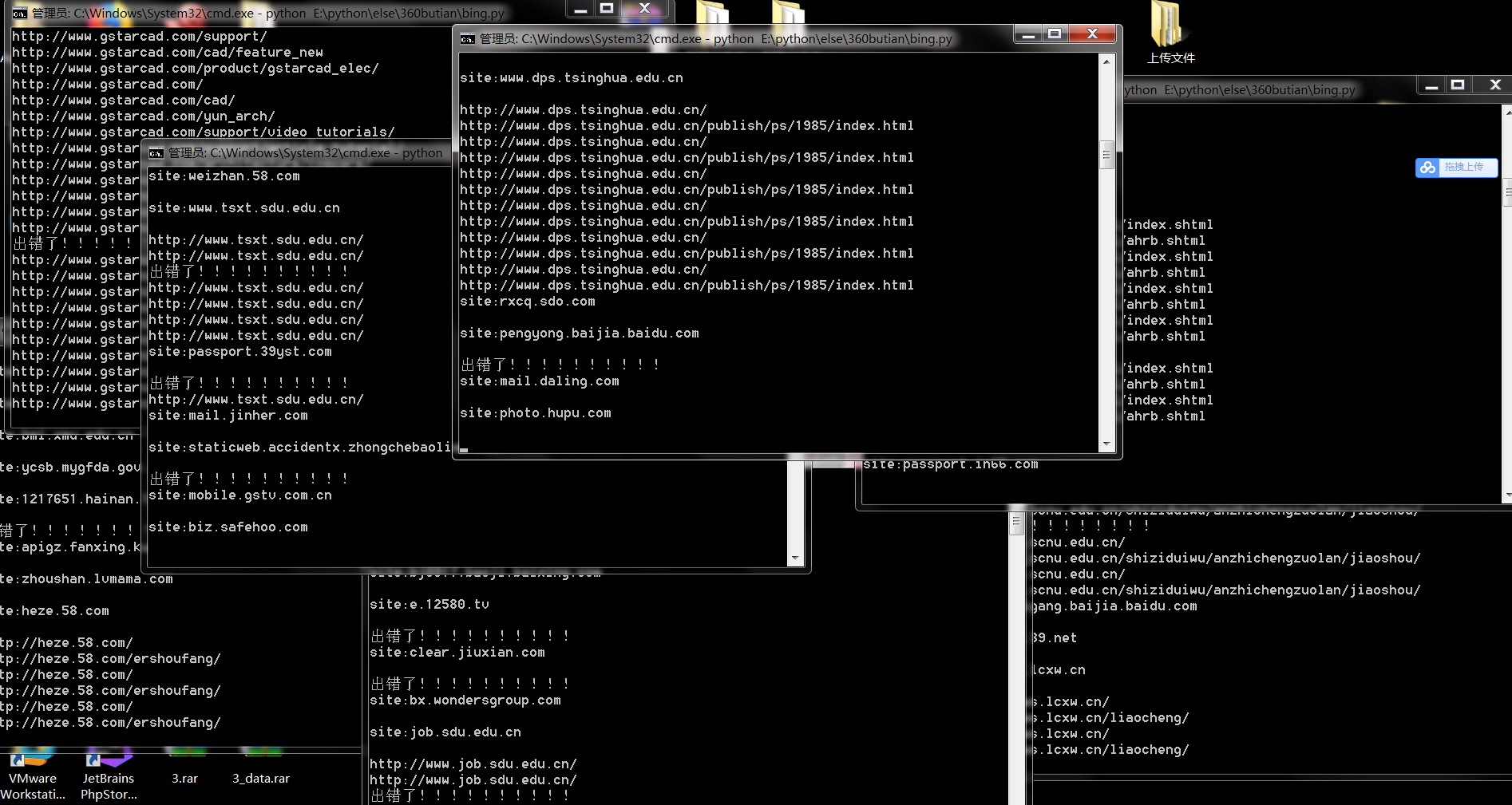

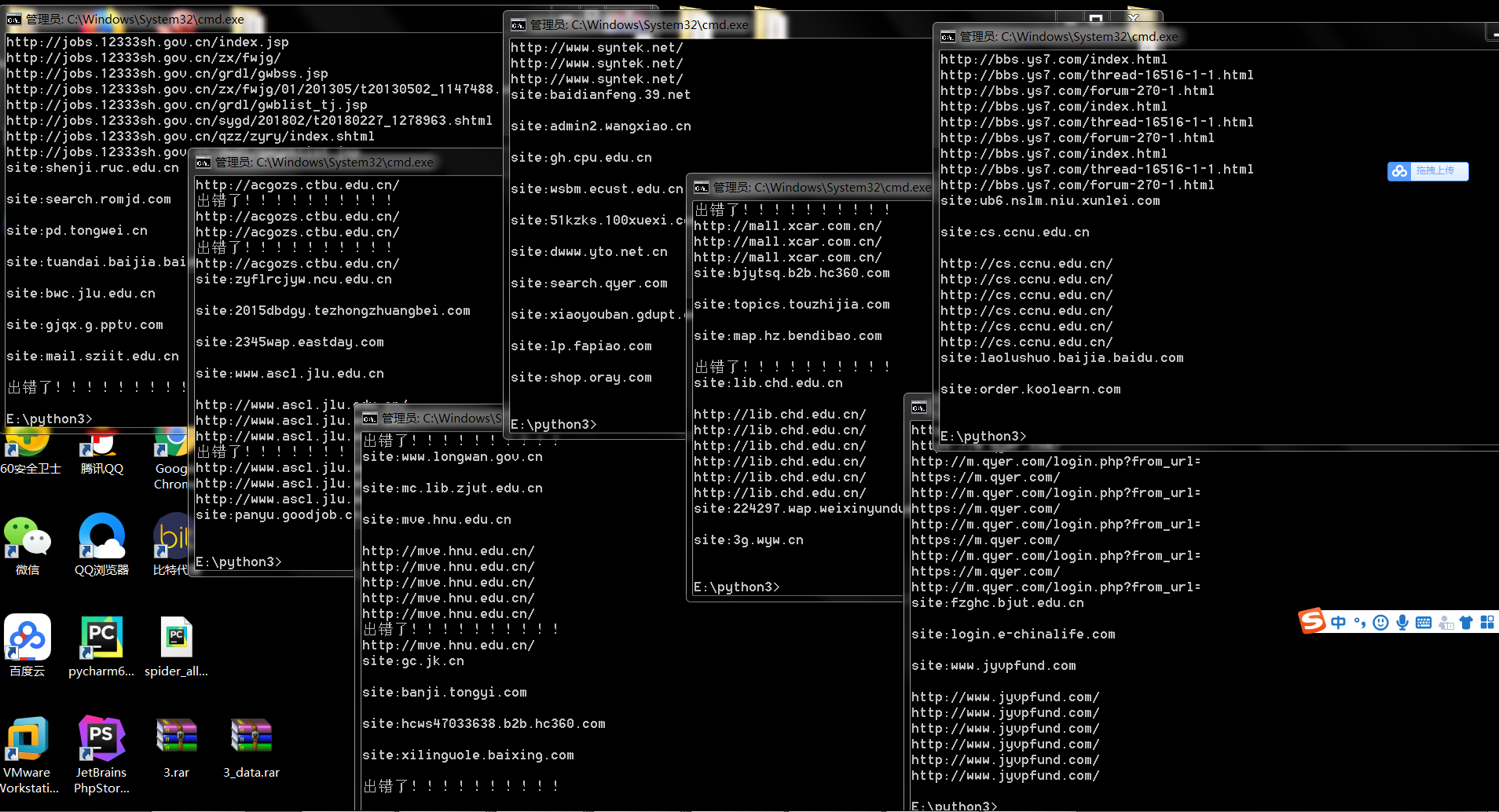

于是乎,我就想把url文件切割,分成多份,多开几个脚本一起跑。

于是我百度找到了个txt杀手。

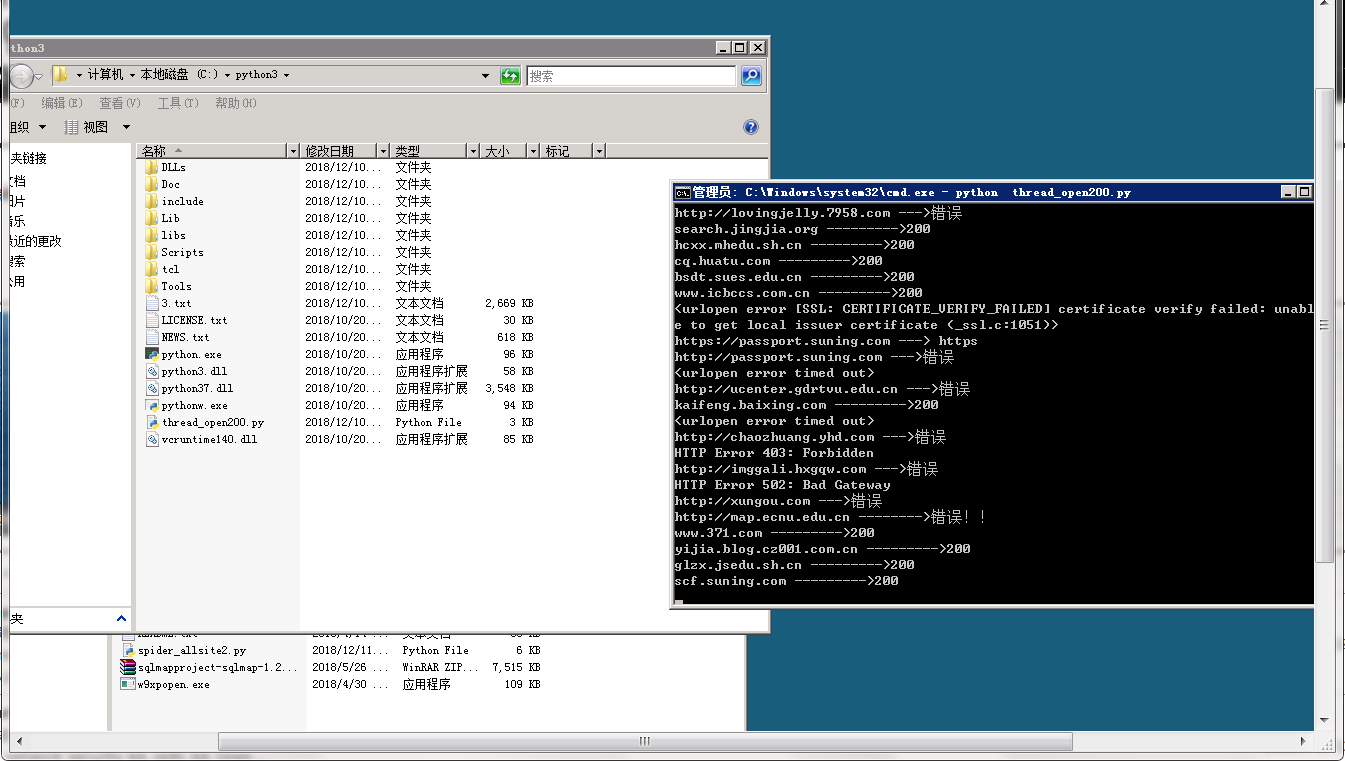

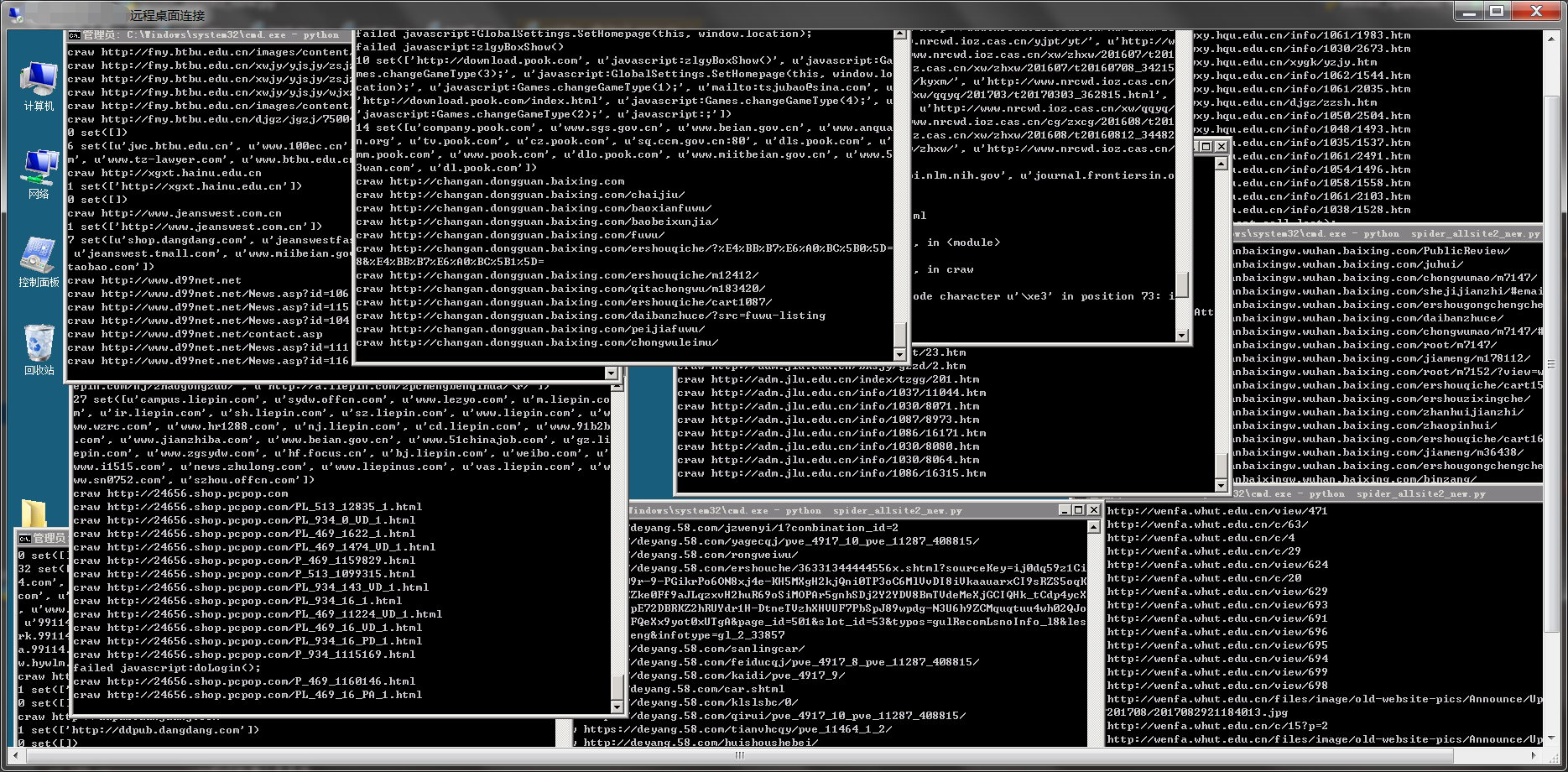

然后把切割好的文件丢到服务器里面跑。

效果开始很不错的,十几万的url一个多小时就搞定了。虽然最后的结果只用了一个多小时,但是前面走不了不少歪路,单线程单开丢到服务器里面跑了好几个小时,,,才发现跑了几千个域名而已。

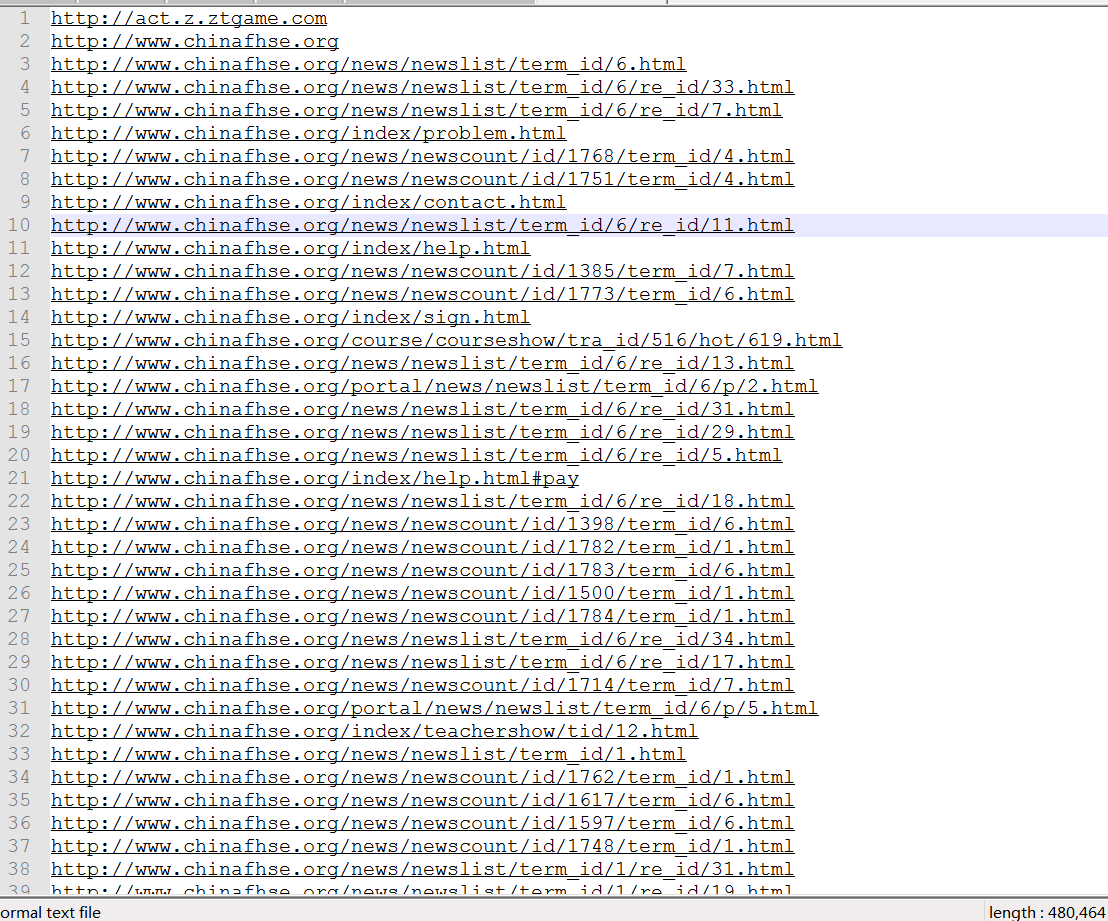

14w左右的url能打开的只有不到一半6w多条左右.

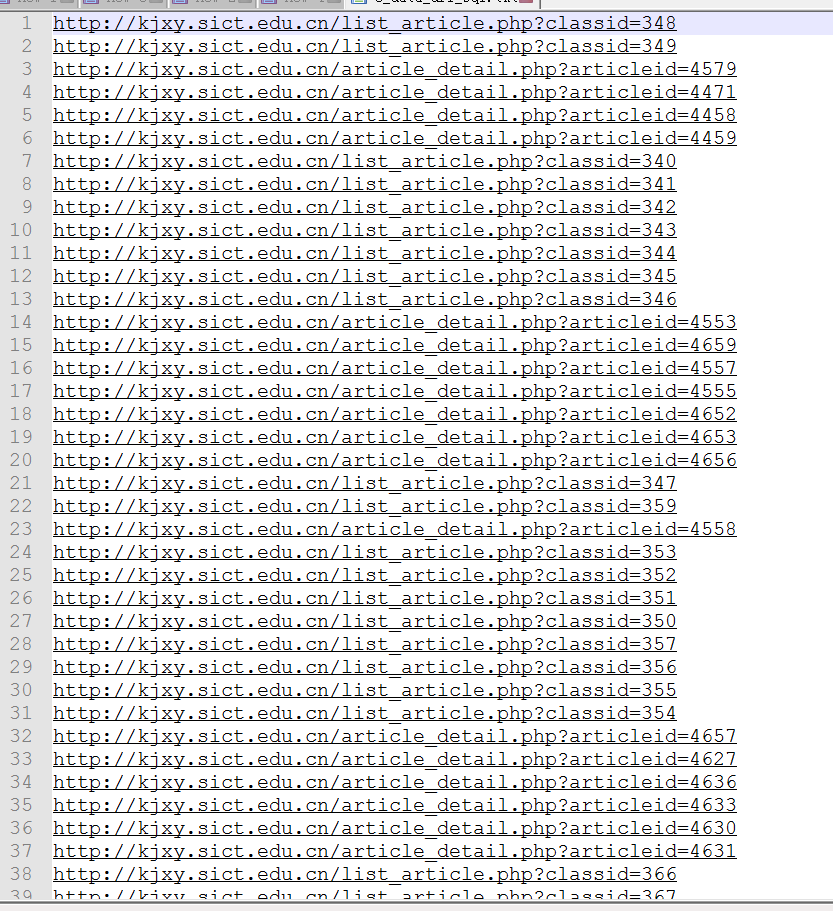

我的思路是把爬抓这些url网站的链接,然后筛选,最后批量注入。

于是乎,我就跑到群里面去问个个老哥有没有批量爬抓网站url的工具,最后果不其然,最后在土司群里一个老哥给了我个py脚本。

原脚本是读取该脚本目录下的url.txt文件,于是我改了下自己输入文件名。毕竟我的url文件是多份的,且我也想多开几个脚本。而且这个脚本没有多线程。

开起来看着效果确实不错,但是几个小时后问题还是出现了。

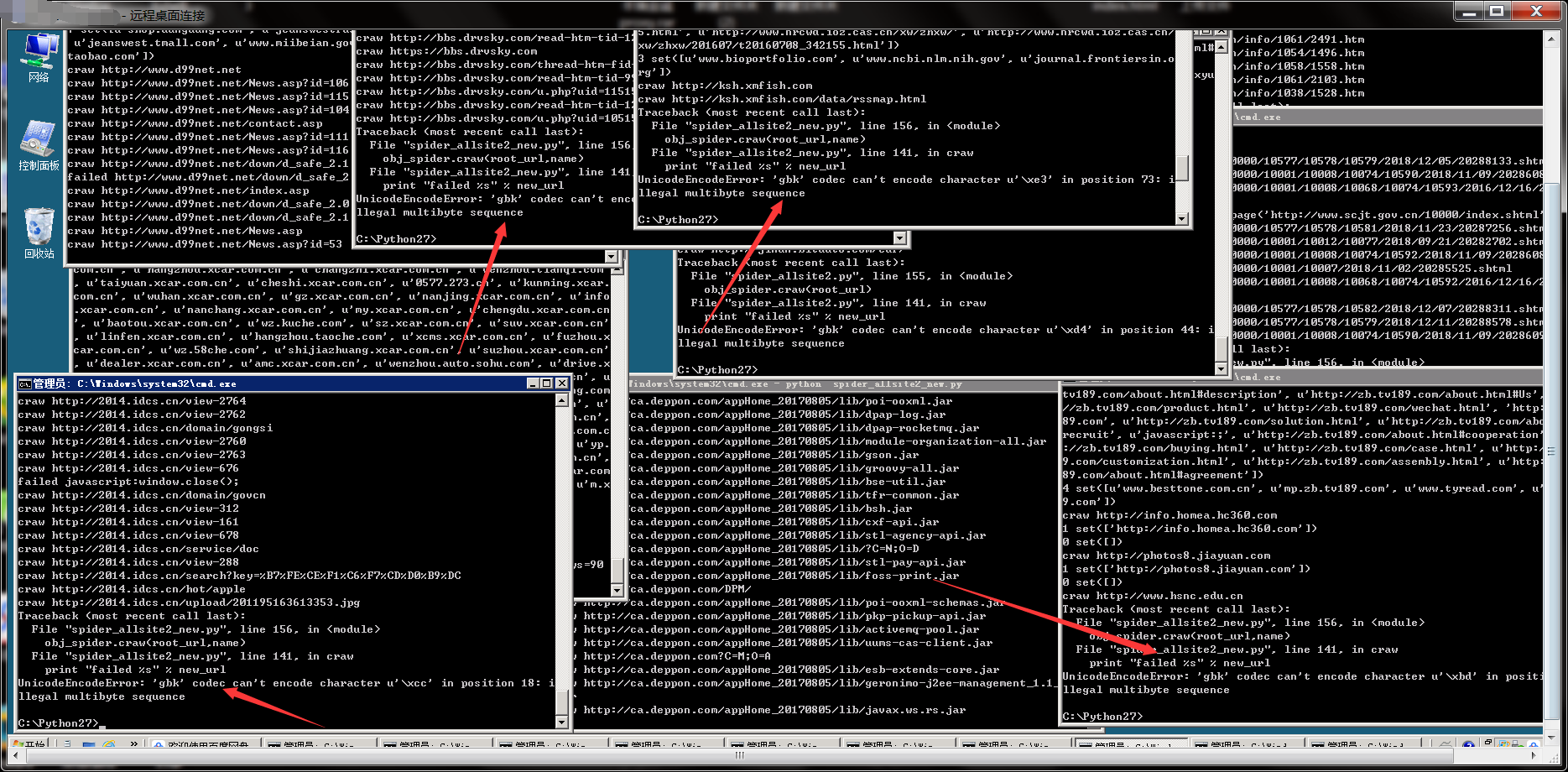

编码错误。。。又跑去改了下脚本把那个问题解决后还把爬整站的url改成只爬100条url,我知道这样可能会损失掉很多存在注入的url,但是为了时间问题我觉得还是要改的,不然爬个一个月都不一定能爬完。

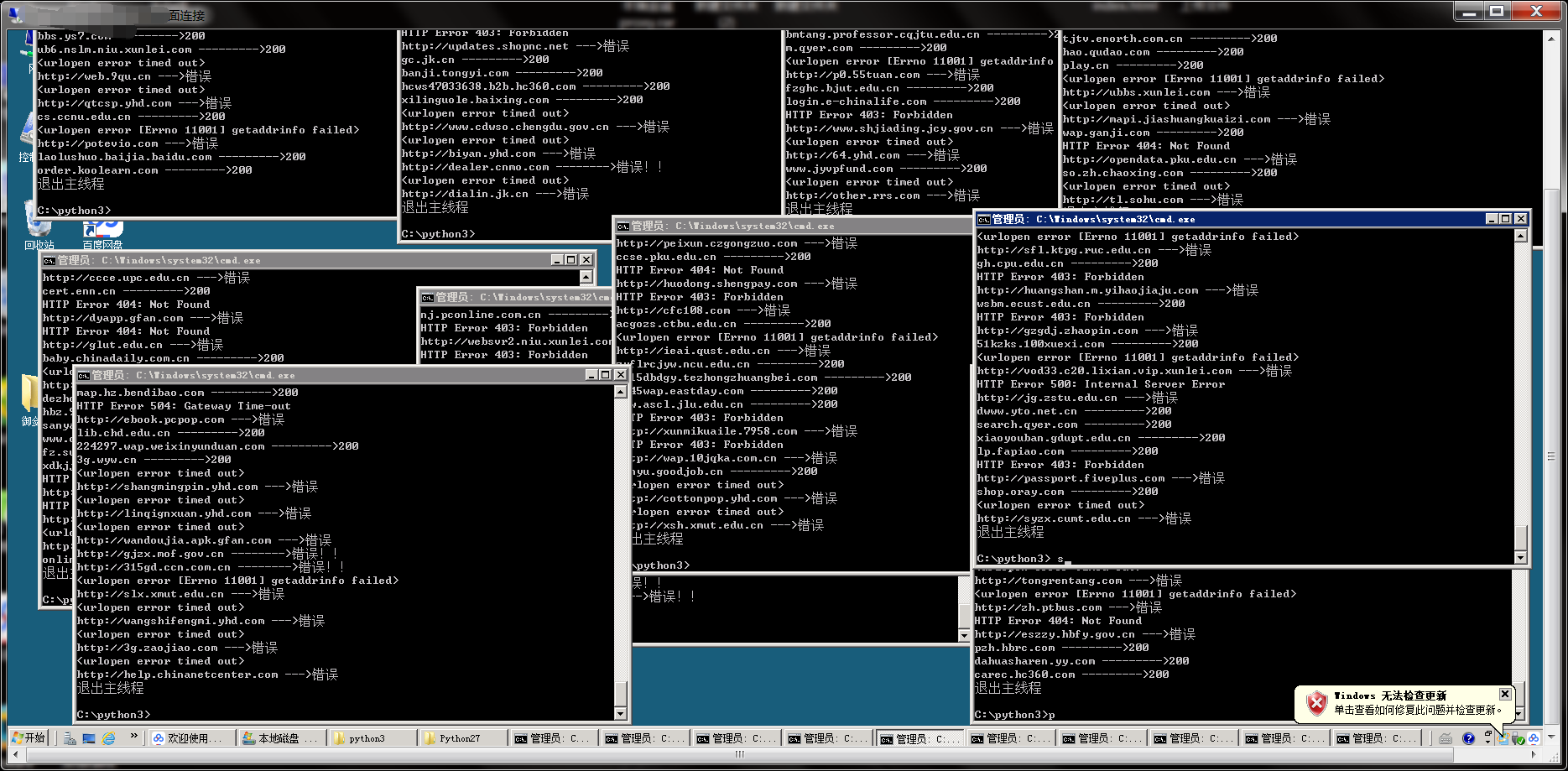

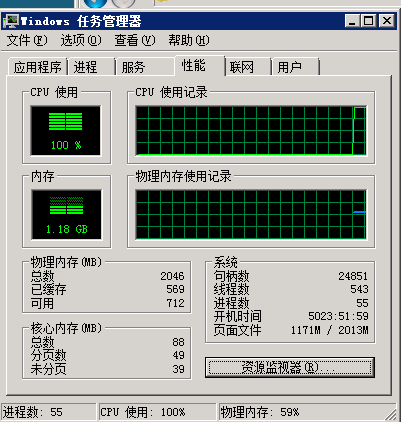

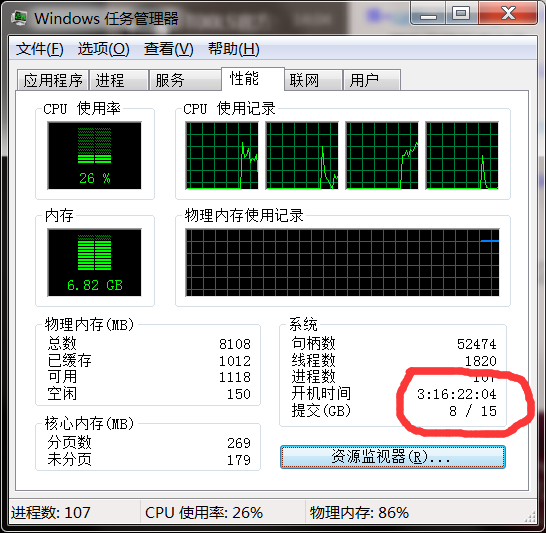

几十个小时后..我登服务器看 我那个渣渣服务器卡爆了而且脚本都不动了。cpu一直是100。

可能我这个服务器是真的太渣了,当时搞活动99块一年买的,我觉得这个价格这个配置我已经很满足了。

关掉所有的脚本后,我把已经爬好的url先合并成一个。

然后在进行一遍筛选,把带有.asp?、aspx?、php?、jsp? 的url提取出来。

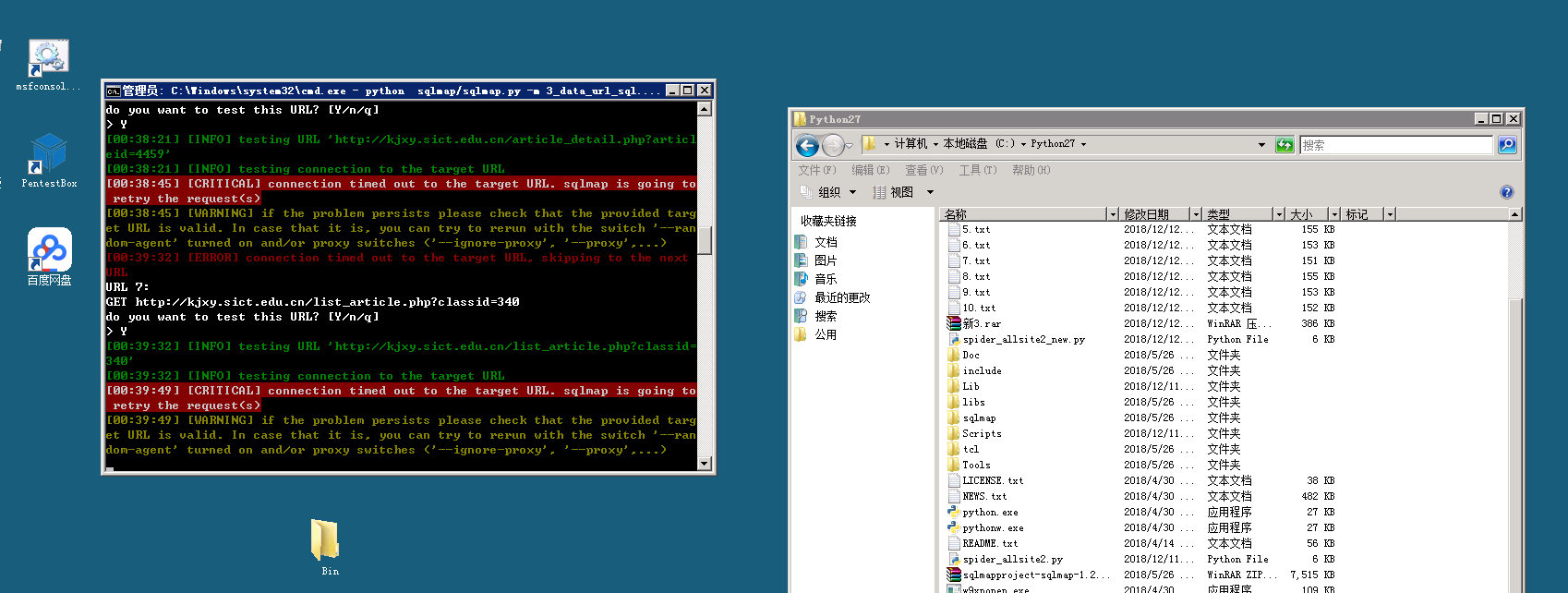

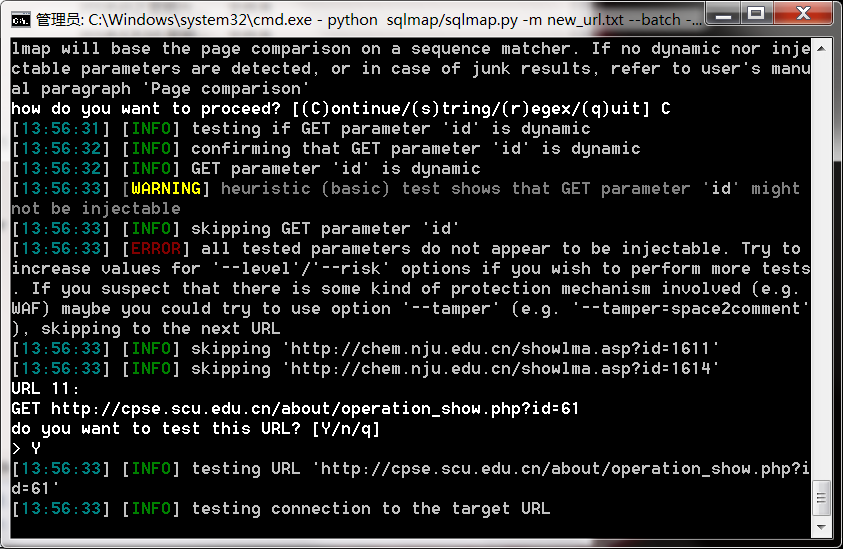

然后丢到sqlmap里面批量跑注入。

sqlmap.py -m url.txt –batch –smart

-m是用url.txt里面的链接批量注入 –batch自动选择 –smart快速注入

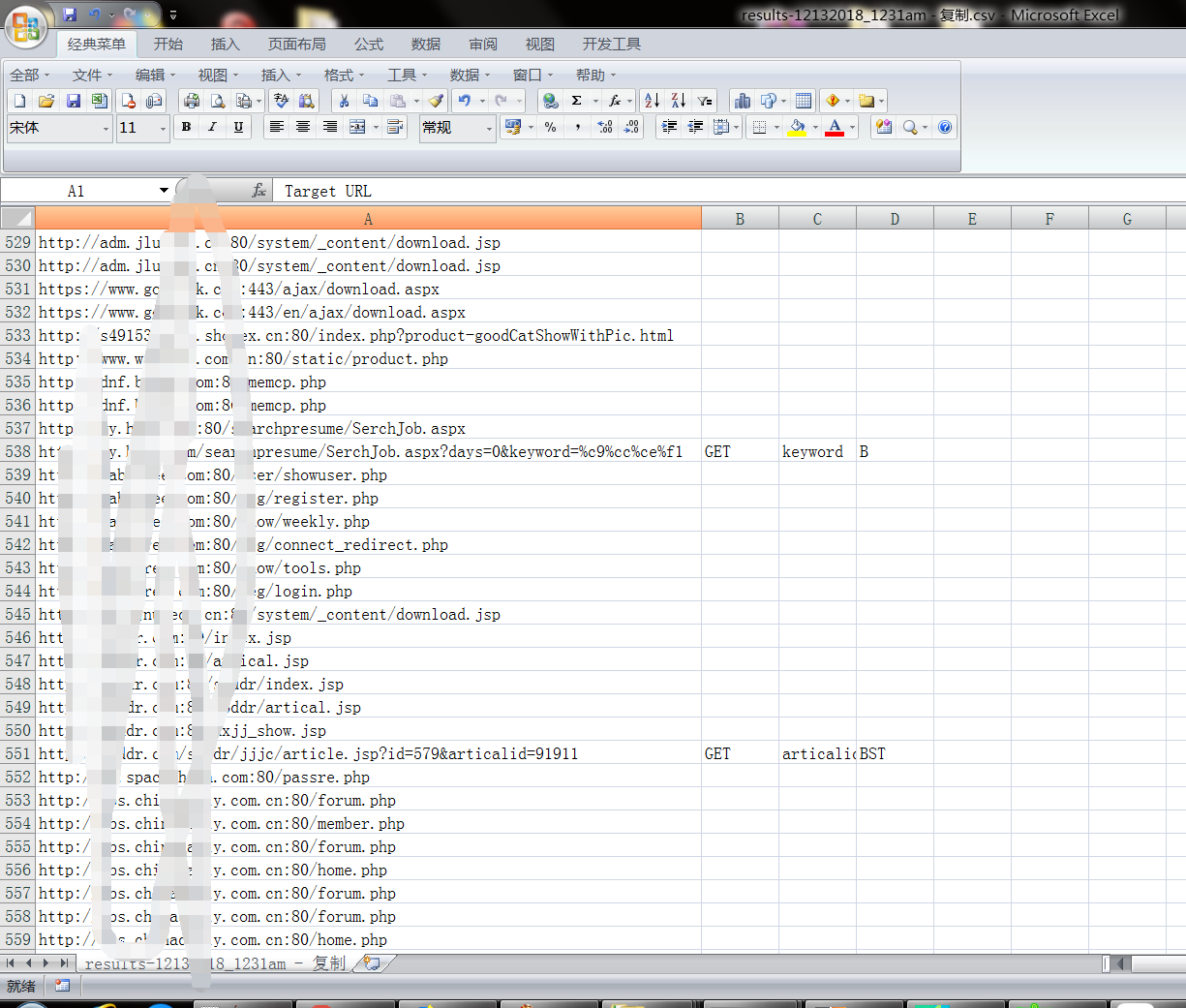

注入的结果在C:\Users\Administrator.sqlmap\output 文件下

类似results-04242018_1222pm.csv的文件中

然后又开着爬取url的脚本继续爬。。。

最后sqlmap跑出的结果实在是

才寥寥几个 虽然爬取网站url的脚本才跑了不到三分之一的url,可是这个结果真的不忍直视,我知道没爬完整站会丢失掉很多存在注入的url,可是这个结果真的无法接受,我觉得这个思路可能有问题,如果爬整站的话效果可能最优,但是时间问题确实不予许,爬100条数据的话基本都是相差不大的url只是改了下参数后面是值而已。

看来只能另寻它法了。

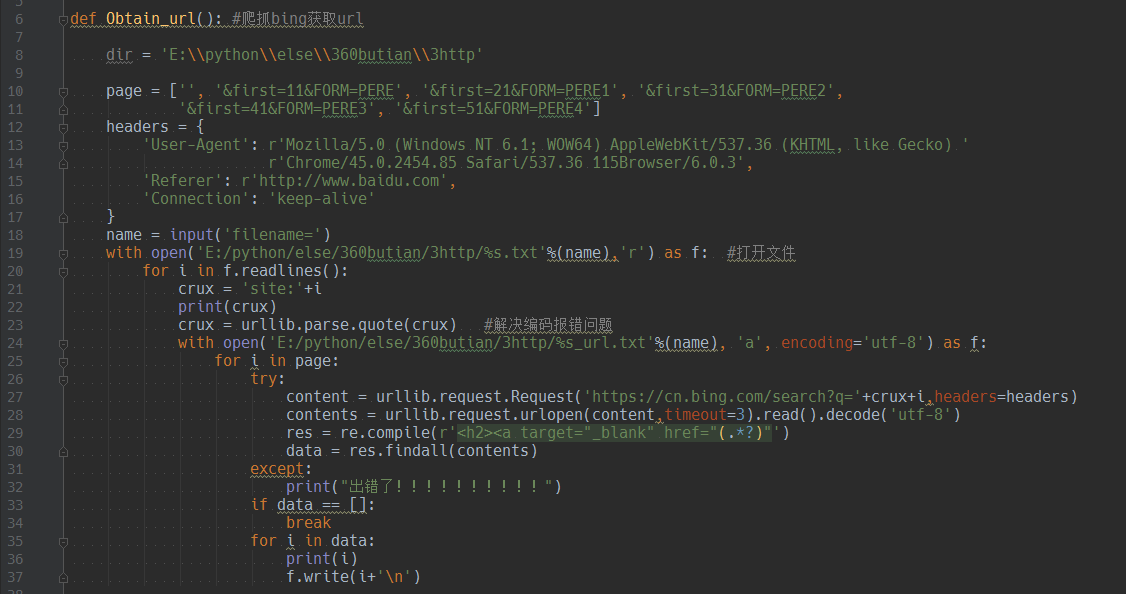

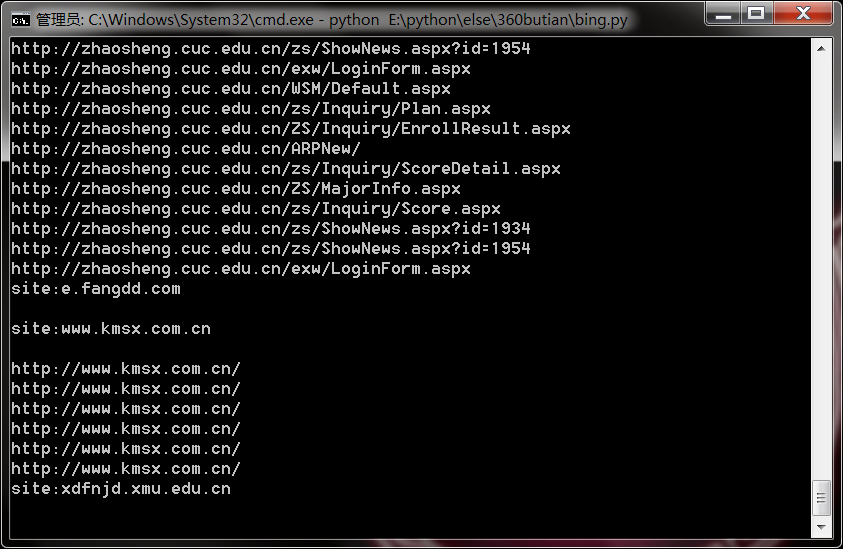

最后我决定利用搜索引擎来解决这个问题,每个网站去bing里面site一遍。如果有site到链接的话就继续访问下一页,没有的话就换下个网站,最多访问到bing第五页site的结果。

看起来效果也挺不错,于是当然是选择多开几个脚本一起跑啦,由于服务器已经在跑那个脚本了,所以我就用我的笔记本跑了。

时间就是那么不经意间就过去了…..

这过程没发生什么意外,顺利的爬完了6w多个网址。

得到的结果,先去重,然后接着把带有.asp?、aspx?、php?、jsp? 的url提取出来。

接着又丢到sqlmap里面批量跑

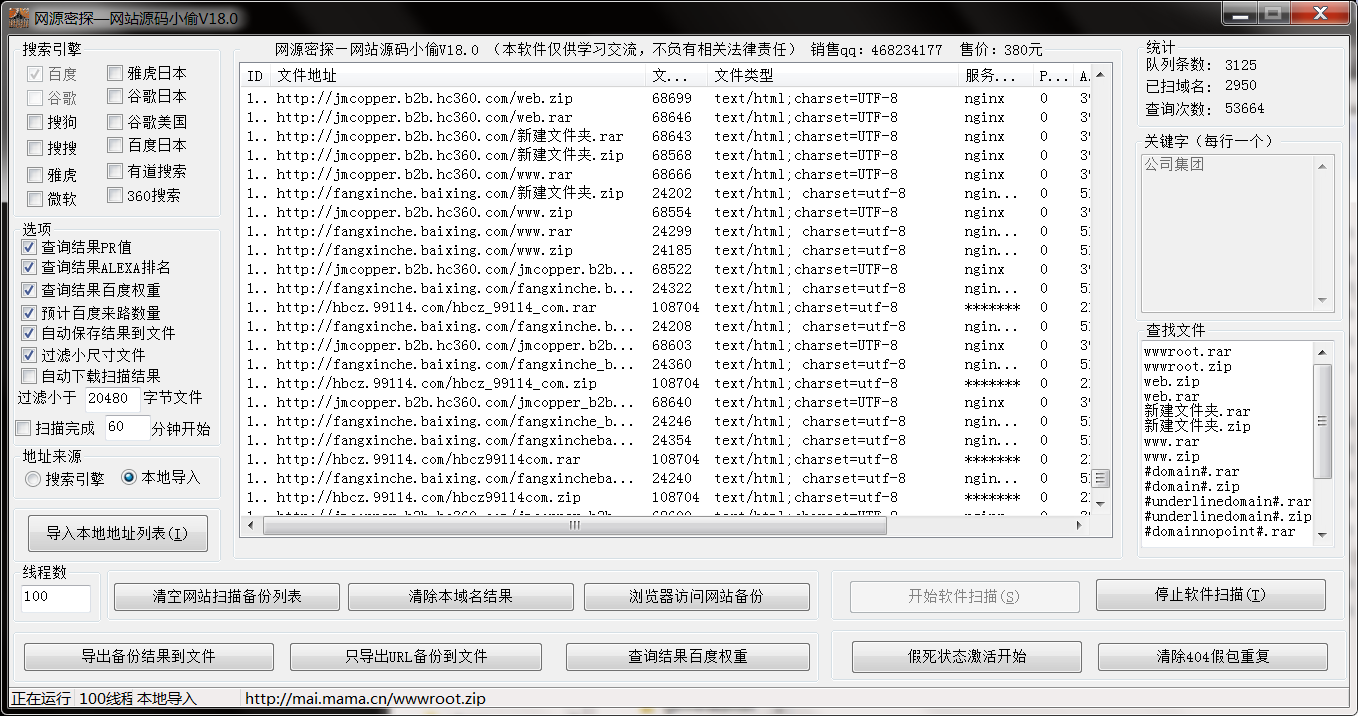

在sqlmap跑着的期间,我拿着能正常打开的6w条域名去跑备份文件。

最后得到的结果还是不错的。

当然还可以拿着这些域名去批量刷其他漏洞,比如.svn文件泄露漏洞.git文件泄露漏洞或者批量识别cms在批量拿exp来咻咻咻什么的都可以,但是我是不想折腾了。

因为提交到补天的结果基本都是漏洞已经重复,这就很难受了。

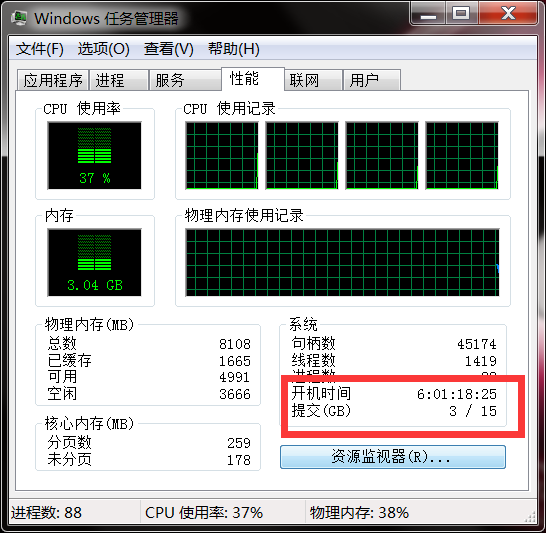

最后记录下笔记本连续6天没关机了.

=============================================

分享下我其中用到的几个脚本:

爬取网站整站的url的脚本原版 python2.x执行 脚本名:spider_allsite2.py

链接:https://pan.baidu.com/s/1RWW61TkOLuo-z3O1d1vrqA

提取码:539q

爬取网站100条的url的脚本 python2.x执行 脚本名:spider_allsite2_new.py

链接:https://pan.baidu.com/s/1ykZFxnGNCWG_nZ0QvXDiRA

提取码:xg0y

通过搜索引擎site网站获取url的脚本 python3.x执行 脚本名:bing.py

链接:https://pan.baidu.com/s/1K6uiSjatiE-DPYNLRGjBnQ

提取码:piz1

多线程访问网站是否200状态 python3.x执行 脚本名:thread_open200.py

链接:https://pan.baidu.com/s/1UV5oZwekMN7cOjjgfdk4pQ

提取码:1x2e